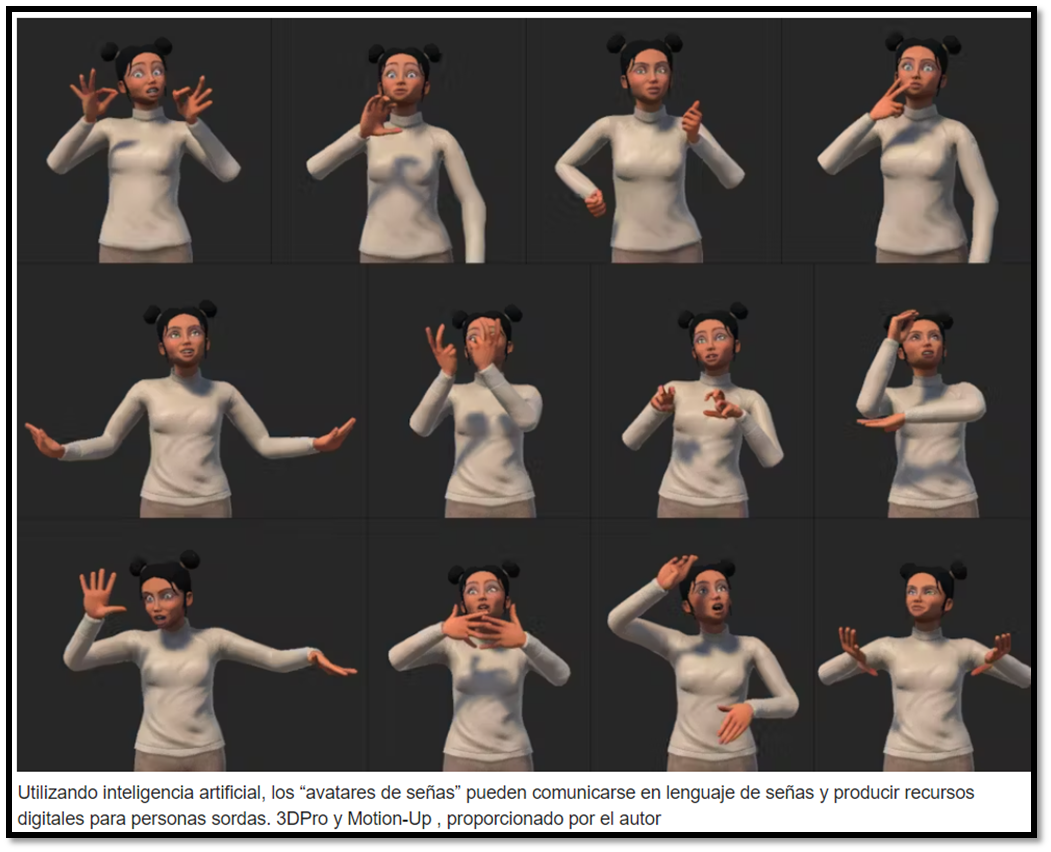

Por Sylvie Gibet Profesor universitario de informática, Université Bretagne Sud Ante los problemas de accesibilidad que afectan a un número cada vez mayor de personas sordas, los investigadores se interesan por las nuevas tecnologías para el aprendizaje de las lenguas de signos. En el ámbito digital, la investigación se centra actualmente en el desarrollo de la inteligencia artificial (IA) que permita traducir automáticamente el lenguaje vocal escrito o hablado al lenguaje de signos y viceversa, utilizando avatares que firman en 3D. Las aplicaciones específicas se refieren en particular a la traducción automática, que permite producir contenidos en lengua de signos a partir de texto (SMS, contenidos web, etc.) o voz, subtitular textualmente vídeos en lengua de signos o incluso diseñar vídeos, aplicaciones educativas y videolibros. destinado a niños sordos. Facilitar la comunicación de las personas sordas y su acceso a la información y promover así su inclusión en la sociedad es el objetivo primordial de este trabajo. Restricciones específicas de las lenguas de signos Las lenguas de signos son lenguas por derecho propio que constituyen pilares de la identidad y las culturas de las personas sordas. Hay tantas lenguas de signos como comunidades de personas sordas, con sus variaciones nacionales, sus especificidades y sus variantes regionales. Son practicados no sólo por las personas sordas, sino también por todas las personas que forman parte de su entorno familiar, educativo y profesional. La lengua de signos francesa (LSF) es el lenguaje de gestos practicado por las personas sordas en Francia. Prohibido durante mucho tiempo, no fue reconocido hasta 2005, lo que puede explicar el hecho de que esté mal equipado con recursos como obras de referencia lexicográficas, gramaticales o incluso enciclopédicas, o incluso datos digitales anotados. Las pocas bases de datos existentes sobre lengua de signos consisten generalmente en vídeos, posiblemente acompañados de traducciones al lenguaje vocal escrito. Esto es particularmente cierto para la LSF, que esencialmente tiene diccionarios léxicos accesibles en la Web. Además, no existe consenso en la comunidad internacional que trabaja en lenguas de signos para definir una forma escrita. Por tanto, es difícil alinear, como ocurre con las lenguas habladas, entre un vídeo en lengua de signos y el texto correspondiente. Por tanto, el desarrollo de herramientas digitales dedicadas a las lenguas de signos plantea importantes cuestiones lingüísticas y tecnológicas. Especificidades lingüísticas Con gramáticas propias, las lenguas de signos están revolucionando las teorías asociadas a las lenguas vocales o escritas. Llevados por modalidades visuales y gestuales, se caracterizan por el paralelismo y la simultaneidad de movimientos y configuraciones de las manos, pero también movimientos no manuales que incluyen la orientación del busto, las expresiones faciales y la dirección de la mirada. Además, se basan en dinámicas icónicas y espaciales. Así, el hablante sordo despliega su discurso en el espacio que lo rodea: posiciona a través de sus gestos las entidades de su discurso, animadas o no, en lugares específicos del espacio que permiten referenciar y recordar estas entidades. La iconicidad, que se expresa por una relación de semejanza entre el gesto y lo que significa, se manifiesta de diferentes maneras. Ciertas configuraciones manuales, portadoras de significado, pueden representar signos léxicos (un avión, una persona) o insertarse en un enunciado. Por ejemplo, la frase "el avión despega" se representa en LSF mediante un único signo realizado con las dos manos: una de las manos (forma plana) representa la pista estática, la otra, dinámica, representa el avión cuyo movimiento sigue su trayectoria relativa a la pista. Estas características icónicas y espaciales, omnipresentes en las lenguas de signos, presuponen mecanismos gramaticales que explotan la geometría en el espacio así como la temporalidad de los movimientos. Esto constituye un desafío técnico a superar para la síntesis de movimientos. Crea avatares de firma animados con captura de movimiento Desde el punto de vista digital, el vídeo, que sigue siendo el medio preferido por las personas sordas, no garantiza el anonimato e impone fuertes limitaciones al almacenamiento y al transporte de datos. Una respuesta adecuada para la producción de la lengua de signos la encontramos en los avatares de signos , personajes virtuales animados en 3D capaces de firmar enunciados. Gracias a las interfaces 3D interactivas que integran estos avatares, es posible editar las animaciones, ralentizarlas, reproducirlas, cambiar el punto de vista o ampliar partes específicas del cuerpo del avatar, o incluso modificar su apariencia gráfica. Diseñar este tipo de avatares de señas requiere primero registrar los movimientos de una persona sorda utilizando técnicas de captura de movimiento ( motion capture o mocap ) y adaptar estos datos a un modelo de personaje en 3D. Durante la última década, la traducción de texto a animación firmada se ha logrado mediante algoritmos basados en datos mocap . Estos algoritmos permiten sintetizar nuevas declaraciones mediante la concatenación de movimientos existentes. Aunque estos enfoques son satisfactorios en términos de precisión y calidad del lenguaje de signos producido, su automatización requiere un procesamiento muy largo, tedioso y complejo de datos mocap . Además, la creación de nuevas expresiones sigue estando limitada por el vocabulario y las estructuras gramaticales de las expresiones inicialmente registradas. Con este tipo de tecnología, parece difícil construir grandes corpus de datos con oraciones que contengan variaciones semánticas en diversos dominios temáticos. Genere contenido en lengua de signos con IA generativa Los avances recientes en IA generativa en el campo de la generación de texto, imágenes o videos abren perspectivas obvias en términos de traducción entre el lenguaje vocal (hablado o escrito) y el lenguaje de signos. La investigación actual tiene como objetivo integrar estos avances mediante el desarrollo de arquitecturas de redes neuronales profundas adaptadas al procesamiento automático del lenguaje. Utilizando algoritmos de aprendizaje automático, aprenden, explotando grandes bases de datos, a identificar y reconocer tendencias y correlaciones ocultas en los datos para producir grandes modelos de lenguaje que son cada vez más eficientes y versátiles. En el contexto de las lenguas de signos, las redes neuronales aprenden en paralelo y en contexto características lingüísticas (por ejemplo, una configuración manual) y cinemáticas (por ejemplo, una secuencia de posturas esqueléticas en 2D o 3D) extraídas de oraciones y movimientos respectivamente. IA para la integración de personas sordas Si se pueden mejorar en un futuro próximo las prestaciones de estos sistemas, en particular en términos de precisión de las animaciones producidas, ya permitirán aumentar considerablemente los recursos disponibles, en particular sustituyendo los vídeos por animaciones de avatar en 3D de alta resolución. Además, métodos calificados de extremo a extremo permitirán diseñar una red neuronal global para tareas complejas de traducción de un idioma a otro. A corto plazo, será posible incluir este tipo de herramienta de traducción automática digital en aplicaciones educativas que exploten las lógicas respectivas de las gramáticas de la lengua vocal y de signos, favoreciendo así el aprendizaje coordinado de las dos lenguas. Estos recursos lingüísticos y herramientas digitales son esenciales para garantizar el acceso de las personas sordas a itinerarios educativos, pasajes esenciales para la adquisición de los conocimientos y habilidades necesarios para una integración exitosa en la sociedad. *****El proyecto SignToKids cuenta con el apoyo de la Agencia Nacional de Investigación (ANR), que financia la investigación basada en proyectos en Francia. Su misión es apoyar y promover el desarrollo de la investigación fundamental y finalizada en todas las disciplinas, y fortalecer el diálogo entre ciencia y sociedad. Para obtener más información, consulte el sitio web de la ANR .