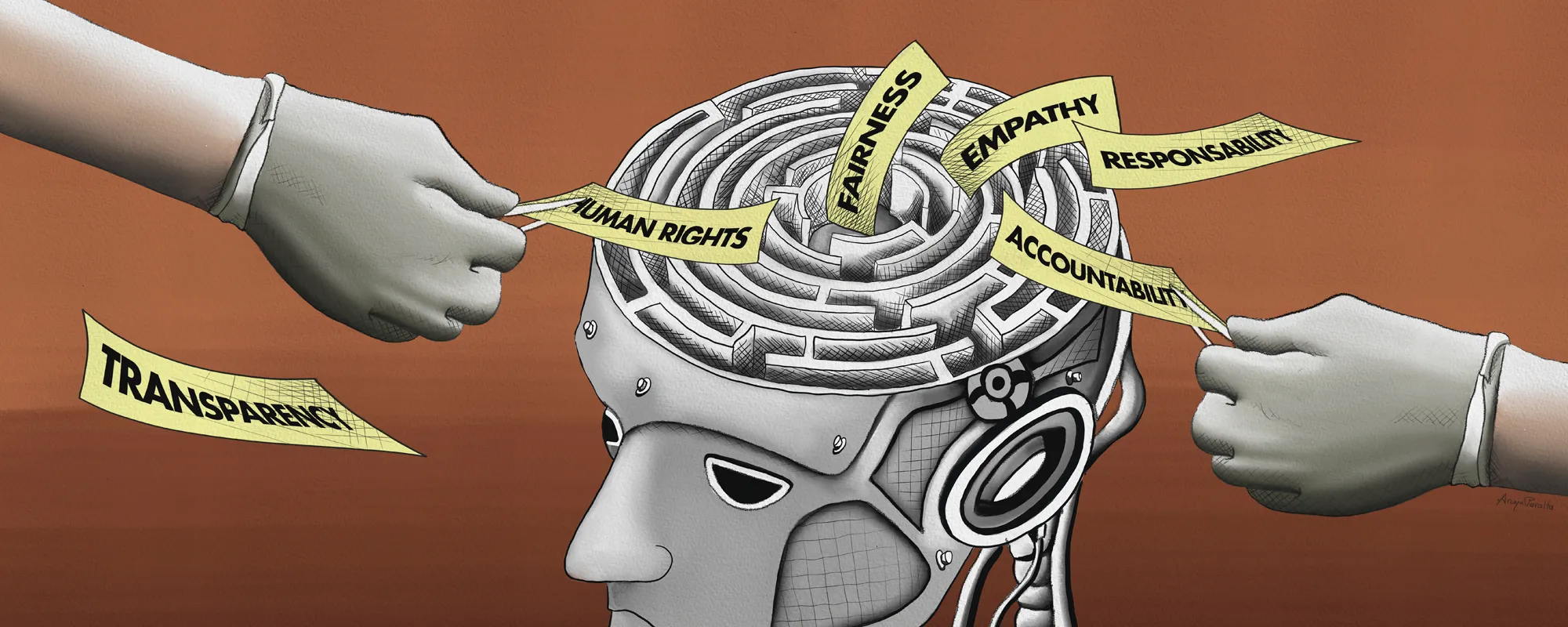

Investigadores del Programa Oxford Martin sobre Arquitecturas Éticas de Web y Datos (EWADA, por sus siglas en inglés) de la Universidad de Oxford han pedido un enfoque más considerado a la hora de incorporar principios éticos en el desarrollo y la gobernanza de la IA para los niños. En un artículo de perspectiva publicado hoy en Nature Machine Intelligence, los autores destacan que, aunque existe un consenso creciente sobre cómo deberían ser los principios éticos de IA de alto nivel, se sabe muy poco sobre cómo aplicarlos de manera efectiva en principio para los niños. En el estudio se cartografió el panorama mundial de las directrices éticas existentes para la IA y se identificaron cuatro retos principales a la hora de adaptar dichos principios en beneficio de los niños: Falta de consideración por el lado del desarrollo de la infancia, especialmente las necesidades complejas e individuales de los niños, los rangos de edad, las etapas de desarrollo, los antecedentes y los personajes. Consideración mínima del papel de los tutores (por ejemplo, los padres) en la infancia. Por ejemplo, a menudo se presenta a los padres como si tuvieran una experiencia superior a la de los hijos, cuando el mundo digital puede necesitar reflexionar sobre este papel tradicional de los padres. Muy pocas evaluaciones centradas en el niño que tengan en cuenta el interés superior y los derechos del niño. Las evaluaciones cuantitativas son la norma a la hora de evaluar cuestiones como la seguridad y la protección en los sistemas de IA, pero tienden a quedarse cortas cuando se tienen en cuenta factores como las necesidades de desarrollo y el bienestar a largo plazo de los niños. Ausencia de un enfoque coordinado, intersectorial e interdisciplinario para formular principios éticos de IA para los niños que son necesarios para lograr cambios impactantes en las prácticas. Los investigadores también se basaron en ejemplos y experiencias de la vida real para identificar estos desafíos. Descubrieron que, aunque la IA se está utilizando para mantener a los niños seguros, normalmente mediante la identificación de contenidos inapropiados en línea, ha habido una falta de iniciativa para incorporar principios de salvaguardia en las innovaciones de IA, incluidas las respaldadas por los grandes modelos lingüísticos (LLM). Esta integración es crucial para evitar que los niños se vean expuestos a contenidos sesgados basados en factores como el origen étnico o a contenidos nocivos, especialmente para los grupos vulnerables, y la evaluación de estos métodos debe ir más allá de meras métricas cuantitativas como la exactitud o la precisión. A través de su asociación con la Universidad de Bristol, los investigadores también están diseñando herramientas para ayudar a los niños con TDAH, considerando cuidadosamente sus necesidades y diseñando interfaces para respaldar el intercambio de datos con algoritmos relacionados con la IA, de manera que estén alineados con sus rutas diarias, habilidades de alfabetización digital y necesidad de interfaces simples pero efectivas. En respuesta a estos desafíos, los investigadores recomendaron: aumentar la participación de las principales partes interesadas, incluidos los padres y tutores, los desarrolladores de IA y los propios niños; prestar un apoyo más directo a los diseñadores y desarrolladores de sistemas de IA de la industria, especialmente implicándolos más en la aplicación de los principios éticos de la IA; establecer mecanismos jurídicos y profesionales de rendición de cuentas centrados en los niños; y Aumentar la colaboración multidisciplinaria en torno a un enfoque centrado en el niño que involucre a las partes interesadas en áreas como la interacción humano-computadora, el diseño, los algoritmos, la orientación política, la ley de protección de datos y la educación. El Dr. Jun Zhao, Oxford Martin Fellow, investigador principal del Departamento de Ciencias de la Computación de la Universidad y autor principal del artículo, dijo: "La incorporación de la IA en la vida de los niños y en nuestra sociedad es inevitable. Si bien cada vez hay más debates sobre quién debe garantizar que las tecnologías sean responsables y éticas, una proporción sustancial de estas cargas recae en los padres y los niños para navegar por este complejo panorama". «Este artículo de perspectiva examinó los principios éticos globales de IA existentes e identificó brechas cruciales y direcciones de desarrollo futuras. Estos conocimientos son fundamentales para guiar a nuestras industrias y a los responsables de la formulación de políticas. Esperamos que esta investigación sirva como un punto de partida significativo para las colaboraciones intersectoriales en la creación de tecnologías éticas de IA para los niños y el desarrollo de políticas globales en este espacio". Los autores esbozaron varios principios éticos de la IA que deberían tenerse especialmente en cuenta en el caso de los niños. Entre ellas se encuentran garantizar un acceso digital justo, igualitario e inclusivo, ofrecer transparencia y rendición de cuentas a la hora de desarrollar sistemas de IA, salvaguardar la privacidad y prevenir la manipulación y la explotación, garantizar la seguridad de los niños y crear sistemas adecuados a la edad, al tiempo que se involucra activamente a los niños en su desarrollo. El profesor Sir Nigel Shadbolt, coautor, director del Programa EWADA, director del Jesus College de Oxford y profesor de Ciencias de la Computación en el Departamento de Ciencias de la Computación, dijo: "En una era de algoritmos impulsados por IA, los niños merecen sistemas que satisfagan sus necesidades sociales, emocionales y cognitivas. Nuestros sistemas de IA deben ser éticos y respetuosos en todas las etapas del desarrollo, pero esto es especialmente crítico durante la infancia". Lea el estudio «Desafíos y oportunidades para traducir los principios éticos de la IA en la práctica para los niños aquí» en Nature Machine Intelligence. https://www.nature.com/articles/s42256-024-00805-x