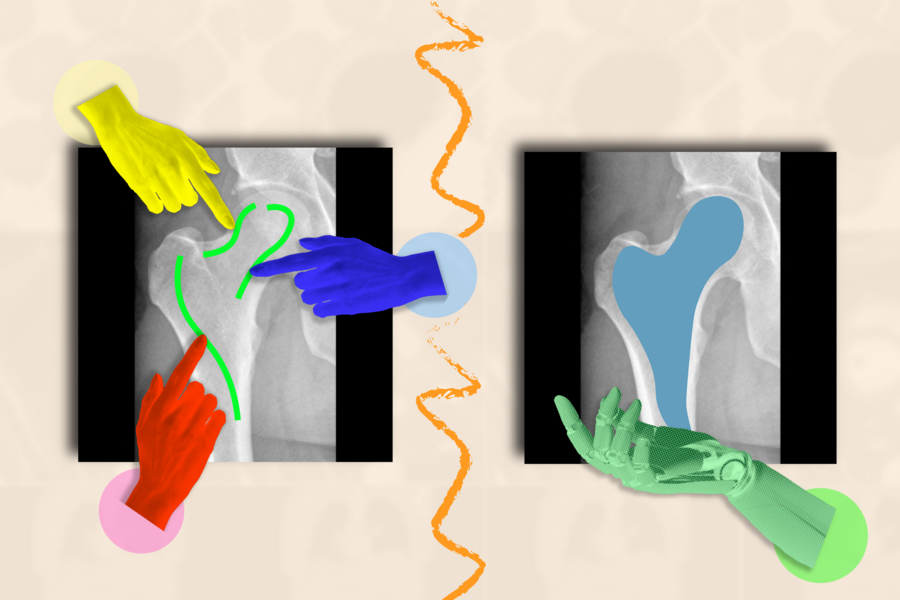

Por Alex Shipps Para el ojo inexperto, una imagen médica como una resonancia magnética o una radiografía parece ser una colección turbia de manchas en blanco y negro. Puede ser difícil descifrar dónde termina una estructura (como un tumor) y comienza otra. Cuando se entrenan para comprender los límites de las estructuras biológicas, los sistemas de IA pueden segmentar (o delinear) regiones de interés que los médicos y trabajadores biomédicos desean monitorear para detectar enfermedades y otras anomalías. En lugar de perder un tiempo precioso trazando la anatomía a mano a través de muchas imágenes, un asistente artificial podría hacerlo por ellos. ¿El truco? Los investigadores y los médicos deben etiquetar innumerables imágenes para entrenar su sistema de IA antes de que pueda segmentar con precisión. Por ejemplo, tendrías que anotar la corteza cerebral en numerosas resonancias magnéticas para entrenar a un modelo supervisado para comprender cómo puede variar la forma de la corteza en diferentes cerebros. Evitando esta tediosa recopilación de datos, investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT, el Hospital General de Massachusetts (MGH) y la Escuela de Medicina de Harvard han desarrollado el marco interactivo "ScribblePrompt": una herramienta flexible que puede ayudar a segmentar rápidamente cualquier imagen médica, incluso los tipos que no ha visto antes. En lugar de que los humanos marcaran cada imagen manualmente, el equipo simuló cómo los usuarios anotarían más de 50.000 escaneos, incluidas resonancias magnéticas, ultrasonidos y fotografías, en las estructuras de los ojos, las células, el cerebro, los huesos, la piel y más. Para etiquetar todos esos escaneos, el equipo utilizó algoritmos para simular cómo los humanos garabatearían y harían clic en diferentes regiones de las imágenes médicas. Además de las regiones comúnmente etiquetadas, el equipo también utilizó algoritmos de superpíxeles, que encuentran partes de la imagen con valores similares, para identificar posibles nuevas regiones de interés para los investigadores médicos y entrenar a ScribblePrompt para segmentarlas. Estos datos sintéticos prepararon a ScribblePrompt para manejar las solicitudes de segmentación del mundo real de los usuarios. "La IA tiene un potencial significativo en el análisis de imágenes y otros datos de alta dimensión para ayudar a los humanos a hacer las cosas de manera más productiva", dice la estudiante de doctorado del MIT Hallee Wong SM '22, autora principal de un nuevo artículo sobre ScribblePrompt y afiliada de CSAIL. "Queremos aumentar, no reemplazar, los esfuerzos de los trabajadores médicos a través de un sistema interactivo. ScribblePrompt es un modelo simple con la eficiencia necesaria para ayudar a los médicos a centrarse en las partes más interesantes de su análisis. Es más rápido y preciso que los métodos de segmentación interactivos comparables, lo que reduce el tiempo de anotación en un 28 por ciento en comparación con el marco Segment Anything Model (SAM) de Meta, por ejemplo". La interfaz de ScribblePrompt es simple: los usuarios pueden garabatear a través del área aproximada que les gustaría segmentar, o hacer clic en ella, y la herramienta resaltará toda la estructura o el fondo según lo solicitado. Por ejemplo, puede hacer clic en venas individuales dentro de un escaneo de retina (ojo). ScribblePrompt también puede marcar una estructura dado un cuadro delimitador. A continuación, la herramienta puede realizar correcciones en función de los comentarios del usuario. Si desea resaltar un riñón en una ecografía, puede usar un cuadro delimitador y, a continuación, garabatear partes adicionales de la estructura si ScribblePrompt omite algún borde. Si desea editar su segmento, puede usar un "garabato negativo" para excluir ciertas regiones. Estas capacidades interactivas y autocorrectivas hicieron de ScribblePrompt la herramienta preferida entre los investigadores de neuroimagen de MGH en un estudio de usuarios. El 93,8 por ciento de estos usuarios favoreció el enfoque de MIT sobre la línea de base de SAM para mejorar sus segmentos en respuesta a las correcciones de garabatos. En cuanto a las ediciones basadas en clics, el 87,5 por ciento de los investigadores médicos prefirió ScribblePrompt. ScribblePrompt se entrenó con garabatos simulados y clics en 54.000 imágenes en 65 conjuntos de datos, con escaneos de los ojos, el tórax, la columna vertebral, las células, la piel, los músculos abdominales, el cuello, el cerebro, los huesos, los dientes y las lesiones. El modelo se familiarizó con 16 tipos de imágenes médicas, incluidas microscopias, tomografías computarizadas, radiografías, resonancias magnéticas, ultrasonidos y fotografías. "Muchos métodos existentes no responden bien cuando los usuarios garabatean imágenes porque es difícil simular tales interacciones en el entrenamiento. Para ScribblePrompt, pudimos forzar a nuestro modelo a prestar atención a diferentes entradas utilizando nuestras tareas de segmentación sintética", dice Wong. "Queríamos entrenar lo que es esencialmente un modelo de base con una gran cantidad de datos diversos para que se generalizara a nuevos tipos de imágenes y tareas". Después de recopilar tantos datos, el equipo evaluó ScribblePrompt en 12 nuevos conjuntos de datos. Aunque no había visto estas imágenes antes, superó cuatro métodos existentes al segmentar de manera más eficiente y brindar predicciones más precisas sobre las regiones exactas que los usuarios querían resaltar. "La segmentación es la tarea de análisis de imágenes biomédicas más frecuente, que se realiza ampliamente tanto en la práctica clínica rutinaria como en la investigación, lo que la lleva a ser muy diversa y un paso crucial e impactante", dice el autor principal Adrian Dalca SM '12, PhD '16, científico investigador de CSAIL y profesor asistente en MGH y la Escuela de Medicina de Harvard. "ScribblePrompt fue cuidadosamente diseñado para ser útil en la práctica para los médicos e investigadores y, por lo tanto, para hacer que este paso sea mucho, mucho más rápido". "La mayoría de los algoritmos de segmentación que se han desarrollado en el análisis de imágenes y el aprendizaje automático se basan, al menos hasta cierto punto, en nuestra capacidad para anotar imágenes manualmente", dice el profesor de radiología de la Escuela de Medicina de Harvard y neurocientífico de MGH Bruce Fischl, que no participó en el artículo. "El problema es dramáticamente peor en las imágenes médicas en las que nuestras 'imágenes' son típicamente volúmenes en 3D, ya que los seres humanos no tienen ninguna razón evolutiva o fenomenológica para tener alguna competencia en anotar imágenes 3D. ScribblePrompt permite que la anotación manual se lleve a cabo de manera mucho, mucho más rápida y precisa, al entrenar una red precisamente en los tipos de interacciones que un humano normalmente tendría con una imagen mientras anota manualmente. El resultado es una interfaz intuitiva que permite a los anotadores interactuar de forma natural con los datos de imagen con una productividad mucho mayor de lo que era posible anteriormente". Wong y Dalca escribieron el artículo con otros dos afiliados de CSAIL: John Guttag, profesor Dugald C. Jackson de EECS en el MIT e investigador principal de CSAIL; y la estudiante de doctorado del MIT Marianne Rakic SM '22. Su trabajo fue apoyado, en parte, por Quanta Computer Inc., el Centro Eric y Wendy Schmidt del Instituto Broad, Wistron Corp. y el Instituto Nacional de Imágenes Biomédicas y Bioingeniería de los Institutos Nacionales de Salud, con el apoyo de hardware del Centro de Ciencias de la Vida de Massachusetts. El trabajo de Wong y sus colegas se presentará en la Conferencia Europea sobre Visión por Computador de 2024 y se presentó como una charla oral en el taller de DCAMI en la Conferencia de Visión por Computador y Reconocimiento de Patrones a principios de este año. En el taller se les concedió el premio Bench-to-Bedside Paper Award por el posible impacto clínico de ScribblePrompt.

Publicado el 11 sep. 2024

Un enfoque rápido y flexible para ayudar a los médicos a anotar las exploraciones médicas