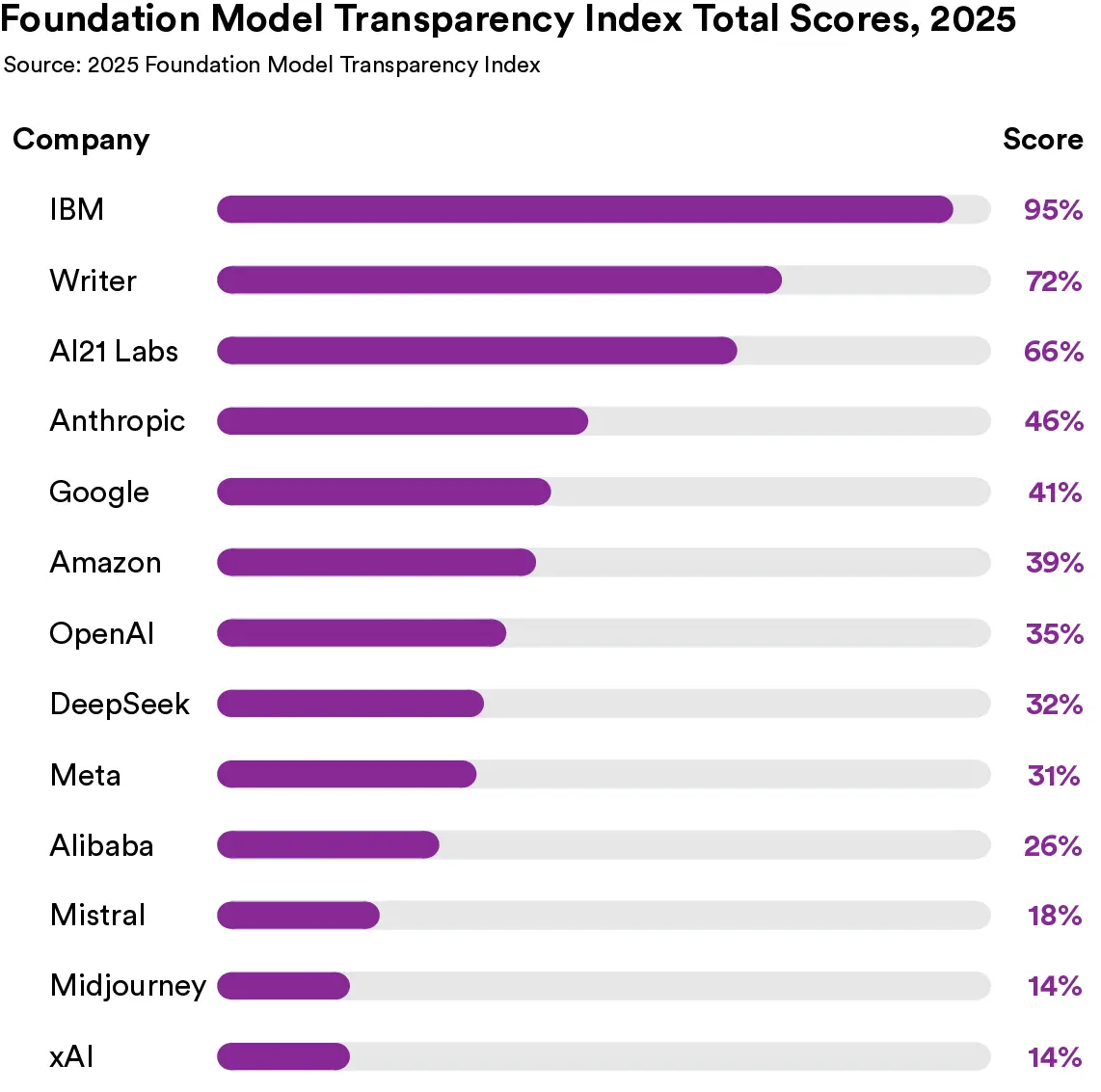

Las empresas de IA, y la industria de la IA en su conjunto, nunca han sido tan importantes. Siete empresas consolidadas de IA, entre ellas Google y Meta, representan más del 35 % del S&P 500. Startups como OpenAI y Anthropic son las empresas privadas más valiosas de la historia. Miles de millones de personas utilizan ahora modelos de base para buscar información, ayudarse en la escritura y generar imágenes, vídeos y audio. Pero ¿cuán transparentes son las empresas que construyen nuestro futuro colectivo? Hoy, nuestro equipo de investigadores de Stanford, Berkeley, Princeton y el MIT publicó el Índice de Transparencia del Modelo Fundacional 2025 , la tercera edición del Índice de Transparencia del Modelo Fundacional anual. Observamos que la transparencia ha disminuido desde 2024, y el grado de transparencia de las empresas varía considerablemente. El Índice de Transparencia del Modelo Fundacional es un informe anual que evalúa exhaustivamente la transparencia de las principales empresas de IA en relación con sus modelos estrella. Cada empresa se califica en una escala de 100 puntos que abarca temas como datos de entrenamiento, mitigación de riesgos e impacto económico. El índice de este año establece que el nivel de transparencia en la industria es bajo. En una escala de 100 puntos, las empresas obtuvieron una puntuación media de tan solo 40 puntos. Si bien el promedio es bajo, las empresas varían considerablemente en sus prácticas. Se distinguen tres grupos: las de mejor desempeño obtuvieron una puntuación de alrededor de 75, las de rango medio obtuvieron una puntuación de alrededor de 35 y las de bajo desempeño promediaron alrededor de 15. En la cima, IBM obtuvo la puntuación más alta en la historia del Índice, con 95/100. Cabe destacar que IBM sienta un precedente en la industria al divulgar información sobre múltiples indicadores, algo que ninguna otra empresa comparte. Por ejemplo, IBM es la única empresa que proporciona suficiente detalle para que investigadores externos repliquen sus datos de entrenamiento y otorguen acceso a estos a entidades externas, como auditores. Por otro lado, las puntuaciones de 14/100 de xAI y Midjourney se encuentran entre las más bajas en la historia del Índice. No comparten información sobre los datos utilizados para construir sus modelos, los riesgos asociados a ellos ni las medidas que toman para mitigarlos. En general, las trece empresas que evaluamos comparten poca o ninguna información sobre el impacto ambiental o social de la construcción e implementación de sus modelos base. Estos patrones demuestran que las prácticas actuales de transparencia están determinadas principalmente por el grado en que las empresas individuales deciden priorizar la transparencia, en lugar de los incentivos (o desincentivos) a nivel de toda la industria para la transparencia. Puntuaciones del Índice de Transparencia del Modelo de Fundación de 2023 a 2025 por empresaEl Índice de Transparencia del Modelo de Fundación, que ha monitoreado la transparencia desde 2023, registró una caída general en 2025 y una reorganización importante de los principales actores. Este trabajo revela el estado cambiante de la transparencia corporativa. Dado que el propio ecosistema de IA ha cambiado significativamente en los últimos tres años, el Índice 2025 es la primera edición que actualiza los indicadores originales introducidos en la edición de 2023. Con este cambio de criterio en mente, las puntuaciones han disminuido de un promedio de 58/100 en 2024 a 40/100 en 2025. Las empresas individuales han reducido significativamente su transparencia: la puntuación de Meta bajó de 60 a 31 y la de Mistral de 55 a 18. La edición de 2025 también incluye cuatro empresas por primera vez (Alibaba, DeepSeek, Midjourney, xAI), incluyendo importantes empresas chinas por primera vez. Todas estas empresas se encuentran en la mitad inferior del Índice. Junto con el declive general de la transparencia, la clasificación de las empresas ha experimentado cambios. De las seis empresas que evaluamos cada año, Meta y OpenAI comenzaron en primer y segundo lugar en 2023, pero ahora ocupan el último y el penúltimo lugar, respectivamente. En cambio, AI21 Labs ha ascendido del penúltimo lugar en 2023 al primero en 2025. Estos cambios en la puntuación reflejan cambios importantes en las prácticas de transparencia. Meta no publicó un informe técnico para su modelo insignia, Llama 4. Google se retrasó significativamente en la publicación de una ficha de modelo y un informe técnico para Gemini 2.5, lo que provocó el escrutinio de los legisladores británicos en relación con los compromisos públicos que asumieron para publicar estos documentos. El Índice de Transparencia de Modelos Fundacionales aclara la complejidad del ecosistema de información actual. Toda la industria es sistemáticamente opaca en cuatro temas críticos: datos de entrenamiento, computación de entrenamiento, cómo se utilizan los modelos y el impacto resultante en la sociedad. Cada una de estas áreas vincula a los desarrolladores de modelos fundacionales con la cadena de suministro de IA en general . Dado que muchas de estas áreas han sido consistentemente opacas durante los últimos tres años, el Índice de este año destaca que estas áreas son propicias para la intervención política. Poca información sobre el impacto ambiental Las empresas son muy opacas respecto al impacto ambiental de los modelos de cimentación de edificios. Diez empresas no divulgan información clave sobre el impacto ambiental: AI21 Labs, Alibaba, Amazon, Anthropic, DeepSeek, Google, Midjourney, Mistral, OpenAI y xAI. Esto incluye información sobre el consumo de energía, las emisiones de carbono o el consumo de agua. La ocultación de esta información por parte de las empresas es particularmente significativa, ya que las inversiones masivas en centros de datos han sobrecargado la red eléctrica, contribuyendo al aumento de los precios de la energía en EE. UU. y en otros países. Apertura vs. Transparencia La apertura y la transparencia son conceptos entrelazados que a menudo se usan como sinónimos. Para distinguirlos, decimos que un modelo es abierto si sus ponderaciones están disponibles públicamente, mientras que una empresa es transparente si divulga información significativa sobre sus prácticas. La publicación abierta de las ponderaciones del modelo no garantiza la transparencia en muchos temas, como el cómputo de entrenamiento, la evaluación de riesgos y el uso posterior. Empíricamente, los desarrolladores abiertos tienden a ser más transparentes que sus contrapartes cerradas. Sin embargo, este efecto agregado es susceptible de malentendidos. Si bien dos desarrolladores de modelos abiertos en IBM y AI21 Labs son muy transparentes, tres de los desarrolladores abiertos más influyentes, DeepSeek, Meta y Alibaba, son bastante opacos. Se debe tener precaución al asumir que la decisión de un desarrollador de publicar las ponderaciones de modelos abiertos conferirá mayor transparencia sobre las prácticas de la empresa o el impacto social. Pensando en el futuro Compartir información aislada dentro de las empresas de IA es un bien público esencial para garantizar la gobernanza corporativa, mitigar los daños de la IA y promover una supervisión rigurosa de esta tecnología de vanguardia. La necesidad imperiosa de una mayor transparencia es una prioridad absoluta para las políticas de IA en muchas jurisdicciones. California y la Unión Europea han aprobado leyes que exigen transparencia en torno a los riesgos de la IA de vanguardia. Dean Ball, exasesor de IA en la Casa Blanca y principal autor del Plan de Acción de IA de Estados Unidos, ha propuesto medidas de transparencia como un componente de sentido común en la regulación de la IA. El Índice de Transparencia del Modelo Fundacional puede servir de guía para los responsables políticos, al identificar tanto el estado actual de la información de la industria de la IA como las áreas más resistentes a la mejora con el tiempo sin políticas. Autores: Rishi Bommasani Kevin Klyman Alejandro Wan Percy Liang

Publicado el 16 dic. 2025

Un nuevo estudio muestra que la industria de la IA está ocultando información clave