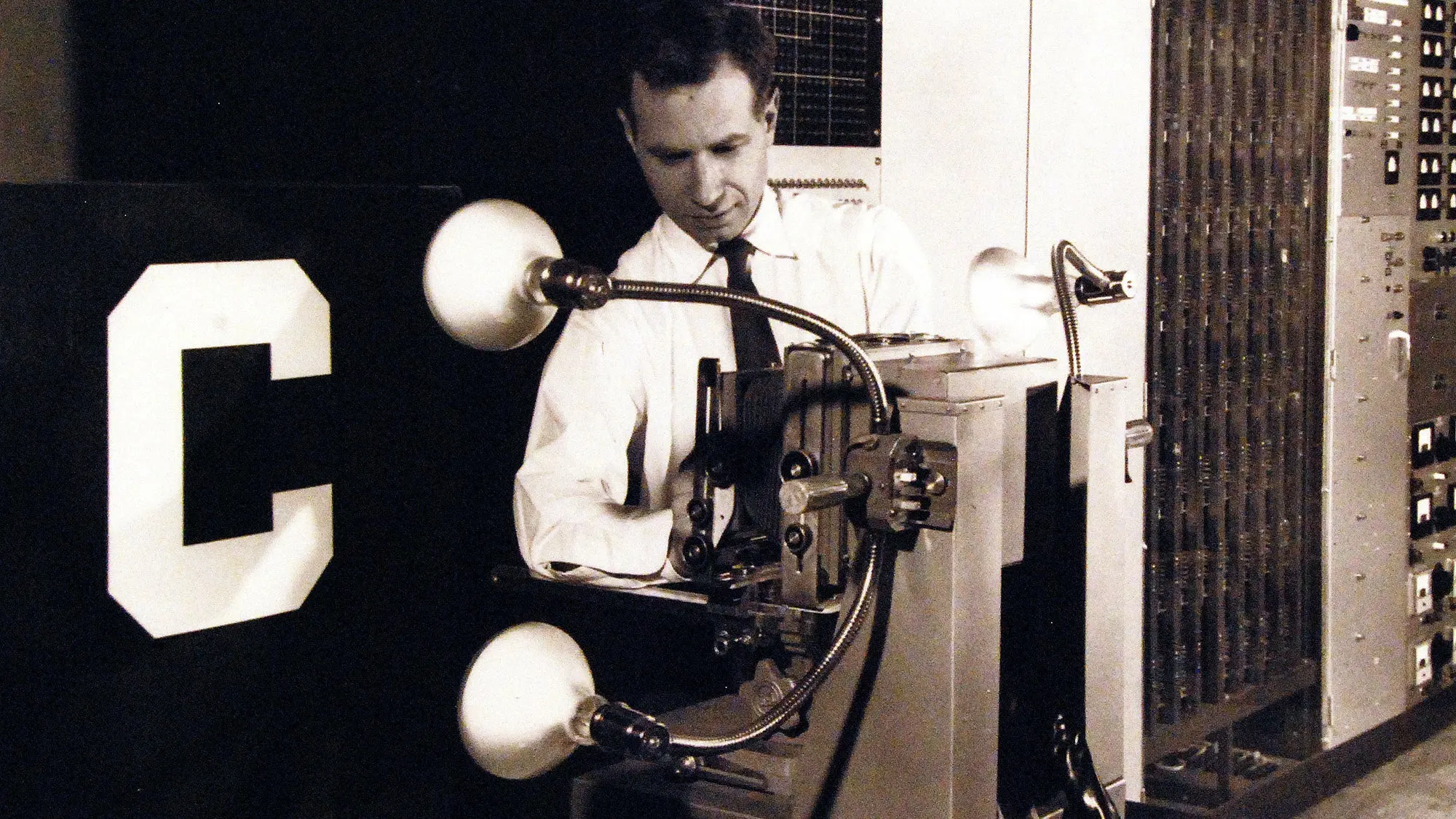

Por Danielle Williams Becario postdoctoral en Filosofía de las Ciencias, Artes y Ciencias en la Universidad de Washington en St. Louis Una computadora del tamaño de una habitación equipada con un nuevo tipo de circuito, el Perceptrón, se presentó al mundo en 1958 en una breve noticia enterrada profundamente en The New York Times. El artículo citaba a la Marina de los EE. UU. diciendo que el Perceptrón conduciría a máquinas que “podrán caminar, hablar, ver, escribir, reproducirse y ser conscientes de su existencia”. Más de seis décadas después, se hacen afirmaciones similares sobre la inteligencia artificial actual. Entonces, ¿qué ha cambiado en los años transcurridos? En cierto modo, no mucho. El campo de la inteligencia artificial ha atravesado un ciclo de auge y caída desde sus inicios. Ahora que el campo se encuentra en otro auge, muchos defensores de esta tecnología parecen haber olvidado los fracasos del pasado... y las razones de ellos. Si bien el optimismo impulsa el progreso, vale la pena prestar atención a la historia. Se podría decir que el perceptrón, inventado por Frank Rosenblatt , sentó las bases de la IA . La computadora analógica electrónica era una máquina de aprendizaje diseñada para predecir si una imagen pertenecía a una de dos categorías. Esta revolucionaria máquina estaba llena de cables que conectaban físicamente diferentes componentes. Las redes neuronales artificiales modernas que sustentan la IA familiar como ChatGPT y DALL-E son versiones de software del Perceptron, excepto que tienen sustancialmente más capas, nodos y conexiones. igual que el aprendizaje automático moderno, si el Perceptrón arrojara una respuesta incorrecta, alteraría sus conexiones para poder hacer una mejor predicción de lo que sucederá la próxima vez. Los sistemas de inteligencia artificial modernos y familiares funcionan de manera muy similar. Utilizando un formato basado en predicciones, los modelos de lenguaje de gran tamaño, o LLM, pueden producir impresionantes respuestas basadas en texto de formato largo y asociar imágenes con texto para producir nuevas imágenes basadas en indicaciones . Estos sistemas mejoran cada vez más a medida que interactúan más con los usuarios. Auge y caída de la IA Aproximadamente una década después de que Rosenblatt presentara el perceptrón Mark I, expertos como Marvin Minsky afirmaron que el mundo “tendría una máquina con la inteligencia general de un ser humano promedio ” hacia mediados o finales de los años setenta. Pero a pesar de algunos éxitos, no se encontró inteligencia humana por ninguna parte. Rápidamente se hizo evidente que los sistemas de IA no sabían nada sobre su tema . Sin los antecedentes y el conocimiento contextual adecuados, es casi imposible resolver con precisión las ambigüedades presentes en el lenguaje cotidiano, una tarea que los humanos realizan sin esfuerzo. El primer “invierno” o período de desilusión de la IA se produjo en 1974, tras el aparente fracaso del Perceptrón . Sin embargo, en 1980, la IA volvió a estar en el negocio y el primer auge oficial de la IA estaba en pleno apogeo. Había nuevos sistemas expertos , IA diseñadas para resolver problemas en áreas específicas del conocimiento, que podían identificar objetos y diagnosticar enfermedades a partir de datos observables . Había programas que podían hacer inferencias complejas a partir de historias simples , el primer automóvil sin conductor estaba listo para salir a la carretera y robots que podían leer y reproducir música tocaban para audiencias en vivo. Pero no pasó mucho tiempo antes de que los mismos problemas sofocaran una vez más el entusiasmo. En 1987, llegó el segundo invierno de IA. Los sistemas expertos estaban fallando porque no podían manejar información nueva . La década de 1990 cambió la forma en que los expertos abordaban los problemas de la IA. Aunque el eventual deshielo del segundo invierno no condujo a un auge oficial, la IA experimentó cambios sustanciales. Los investigadores estaban abordando el problema de la adquisición de conocimientos con enfoques de aprendizaje automático basados en datos que cambiaron la forma en que la IA adquiría conocimientos. Esta vez también marcó un regreso al perceptrón estilo red neuronal, pero esta versión era mucho más compleja, dinámica y, lo más importante, digital. El regreso a las redes neuronales, junto con la invención del navegador web y un aumento en la potencia informática, hizo que fuera más fácil recopilar imágenes, extraer datos y distribuir conjuntos de datos para tareas de aprendizaje automático . Estribillos familiares Si avanzamos rápidamente hasta el día de hoy, la confianza en el progreso de la IA ha comenzado una vez más a hacerse eco de las promesas hechas hace casi 60 años. El término " inteligencia artificial general " se utiliza para describir las actividades de los LLM, como los que impulsan los chatbots de IA como ChatGPT. La inteligencia artificial general, o AGI, describe una máquina que tiene una inteligencia igual a la de los humanos, lo que significa que la máquina sería consciente de sí misma, capaz de resolver problemas, aprender, planificar el futuro y posiblemente ser consciente. Así como Rosenblatt pensó que su Perceptrón era la base para una máquina consciente y parecida a la humana, también lo piensan algunos teóricos contemporáneos de la IA sobre las redes neuronales artificiales actuales. En 2023, Microsoft publicó un artículo que decía que " el rendimiento de GPT-4 se acerca sorprendentemente al rendimiento a nivel humano ". Pero antes de afirmar que los LLM exhiben una inteligencia a nivel humano, podría ser útil reflexionar sobre la naturaleza cíclica del progreso de la IA. Muchos de los mismos problemas que atormentaron a las versiones anteriores de la IA todavía están presentes hoy en día. La diferencia es cómo se manifiestan esos problemas. Por ejemplo, el problema del conocimiento persiste hasta el día de hoy. ChatGPT lucha continuamente por responder a modismos, metáforas, preguntas retóricas y sarcasmo : formas únicas de lenguaje que van más allá de las conexiones gramaticales y, en cambio, requieren inferir el significado de las palabras en función del contexto. Las redes neuronales artificiales pueden, con una precisión impresionante, detectar objetos en escenas complejas. Pero si le damos a una IA una imagen de un autobús escolar tumbado de lado, dirá con mucha confianza que es un quitanieves el 97% de las veces. Lecciones a tener en cuenta De hecho, resulta que la IA es bastante fácil de engañar de maneras que los humanos identificarían inmediatamente. Creo que es una consideración que vale la pena tomar en serio a la luz de cómo han ido las cosas en el pasado. La IA de hoy se ve bastante diferente a la que alguna vez fue, pero los problemas del pasado persisten. Como dice el refrán: Puede que la historia no se repita, pero a menudo rima.

Publicado el 18 mar. 2024

Ya hemos estado aquí antes: la IA prometió máquinas similares a las humanas, en 1958