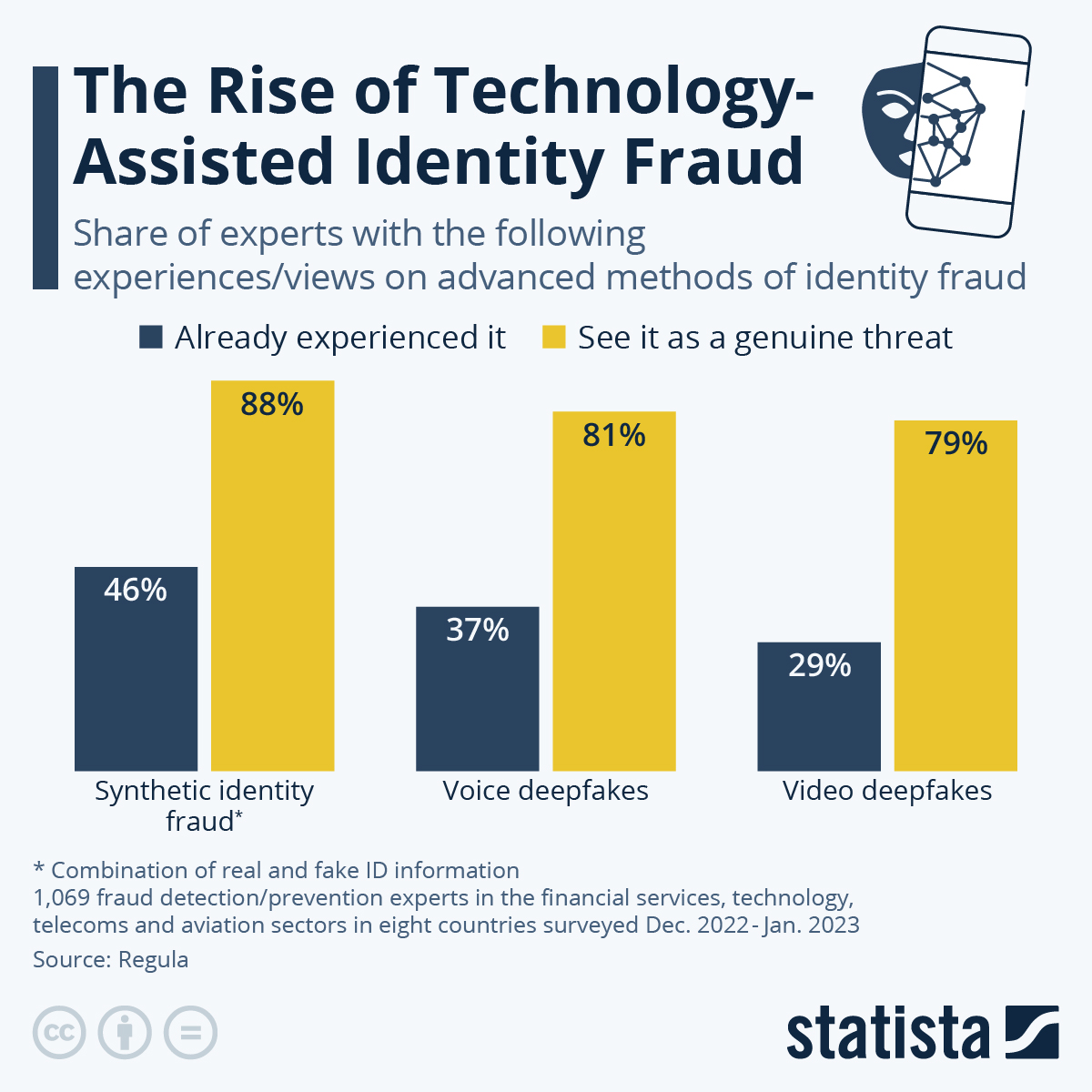

La llamada inteligencia artificial es un tema polémico por varias razones, incluido el manejo de los derechos de autor, el uso de energía, las preocupaciones sobre la privacidad y los chatbots como ChatGPT que a veces devuelven respuestas incorrectas a las consultas. Sin embargo, hay una cosa en la que críticos y evangelistas pueden estar de acuerdo: la IA impregna cada vez más muchas capas de la vida digital, desde la cultura hasta los negocios y la política. Como suele ocurrir con las nuevas tecnologías, un aumento del uso ilícito de la IA en forma de deepfakes está profundamente relacionado con su aumento de popularidad y, lo que es más importante, con su accesibilidad. Los deepfakes son vídeos o formatos de audio generados por IA que se hacen pasar, por ejemplo, por celebridades o políticos para difundir información errónea o desinformación o defraudar a los consumidores. Las empresas de todo el mundo ya pueden sentir el impacto de este tipo de contenido artificial. Una encuesta realizada por el proveedor de verificación de identidad Regula entre más de 1.000 expertos en detección o prevención de fraudes de países como Estados Unidos, Reino Unido, Francia y Alemania muestra que una parte considerable de sus empresas fueron objetivo de uno de los tres métodos de identificación avanzada. fraude. El 46 por ciento de los encuestados experimentó casos de fraude de identidad sintética, donde se utilizó una combinación de componentes de identidad reales y falsos, como un número de seguro social falso y un nombre, dirección y fecha de nacimiento reales. El 37 por ciento informó haber visto el uso de voces profundas, un ejemplo reciente de alto perfil en el ámbito de la política fue un presidente artificial Biden que llamó automáticamente a posibles votantes en enero para disuadirlos de votar en las primarias. Los vídeos deepfakes son, por ahora, menos comunes: sólo el 29 por ciento de los encuestados ya han experimentado este tipo de intentos de fraude. Ahora que las empresas de IA generativa se centran en imágenes en movimiento, con herramientas como Sora de OpenAI, este problema podría volverse más pronunciado en los próximos meses y años. Esta preocupación también se refleja en la proporción de expertos encuestados que creen que estos tres métodos de fraude se convertirán en una verdadera amenaza: entre el 80 y el 90 por ciento están de acuerdo con esta evaluación. "Las identidades falsas generadas por IA pueden ser difíciles de detectar para los humanos, a menos que estén especialmente capacitados para hacerlo", afirma Ihar Kliashchou, director de tecnología de Regula. "Si bien las redes neuronales pueden ser útiles para detectar deepfakes, deberían usarse junto con otras medidas antifraude que se centren en parámetros físicos y dinámicos". https://www.statista.com/chart/32108/experiences-views-of-experts-on-advanced-identity-fraud-methods/