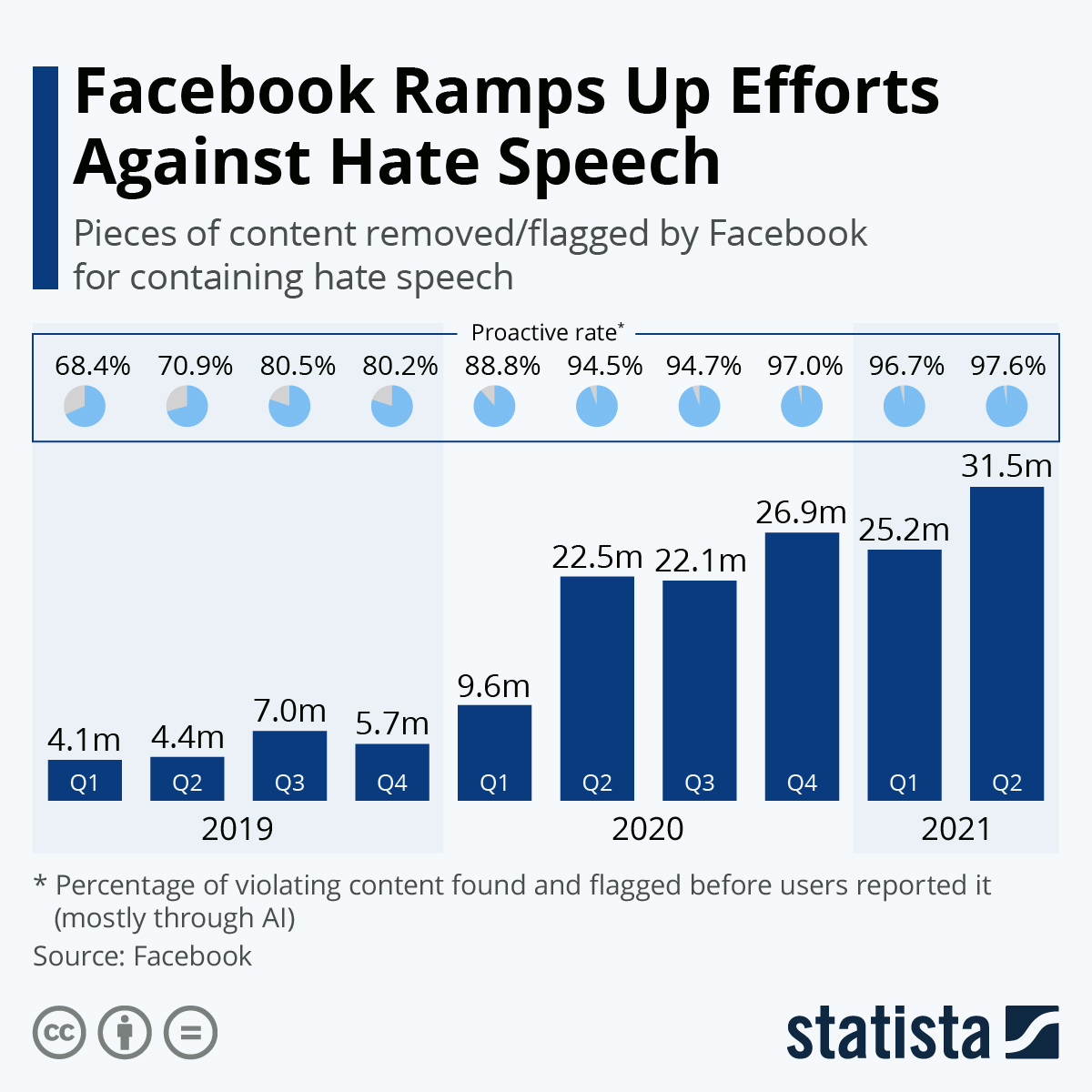

En un intento por aumentar la seguridad digital de periodistas y activistas, Facebook anunció que otorgaría a dichos grupos de usuarios el estatus de "figuras públicas involuntarias" , aumentando efectivamente las medidas de seguridad vigentes para prevenir el acoso y la intimidación. El término se usó ampliamente por primera vez en el contexto del asesinato de George Floyd, lo que permitió a la plataforma eliminar contenido que se burlara o elogiara su muerte. Como muestra nuestro gráfico, Facebook está mejorando en la eliminación de contenido igualmente odioso trimestre tras trimestre. Solo entre abril y junio de 2021, Facebook eliminó o marcó 31,5 millones de piezas de contenido que contenían discursos de odio, un aumento drástico en comparación con la cifra del primer trimestre de 25,2 millones. La tasa de prevalencia de usuarios que encuentran publicaciones y comentarios de odio supuestamente también ha disminuido a aproximadamente 0.05 por ciento, lo que significa que cinco de cada 10,000 piezas de contenido que contienen discursos de odio pasaron por alto los procesos de eliminación y eliminación de marcas de Facebook. Esto se puede atribuir en parte a las mejoras en los algoritmos de IA de la plataforma., que también se reflejan en el porcentaje de contenido que infringe las políticas encontrado antes de que los usuarios lo denunciaran. En el segundo trimestre de 2019, solo el 71 por ciento de las piezas de contenido se eliminaron antes de mostrarse a los usuarios de Facebook, en comparación con aproximadamente el 98 por ciento entre abril y junio de 2021. Sin embargo, depender en gran medida de los algoritmos tiene sus desventajas: en el segundo trimestre de 2021, 416.000 piezas de contenido eliminadas por incitación al odio se restauraron en una fecha posterior, 328.000 a través de procesos automáticos que no requieren una apelación manual. Desde que Facebook comenzó a publicar su Informe de cumplimiento de los estándares comunitarios cada trimestre para crear más transparencia con respecto a sus medidas de moderación, la cantidad total de piezas de contenido marcadas o eliminadas que contienen discursos de odio, así como su tasa de acción proactiva, aumentó continuamente, aparte del primer trimestre de 2021. La empresa define el discurso de odio como “discurso violento o deshumanizante, declaraciones de inferioridad, llamadas a la exclusión o segregación basadas en características protegidas o difamaciones. Estas características incluyen raza, etnia, origen nacional, afiliación religiosa, orientación sexual, casta, sexo, género, identidad de género y discapacidad o enfermedad grave ".